Deep Learning (DL)

활성화 함수 - ReLU 함수 (ReLU function) 란?

심전코

2022. 10. 29. 02:29

활성화 함수(Activation function)

활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고

값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다.

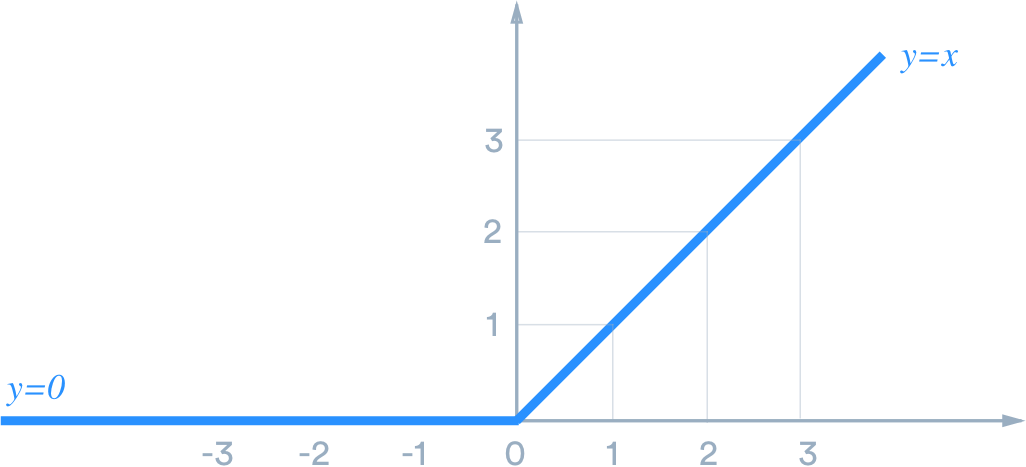

3. ReLU 함수 (ReLU function)

ReLU 함수는

Rectified Linear Unit 의 약자이며,

시그모이드 함수를 중복 해 사용하면 기울기 소실 ( Vanishing Gradient ) 문제가 발생하는데,

기울기 소실 문제를 해결하기 위해 등장한 것이 ReLU 함수이며,

실제로도 많이 사용되는 활성화 함수이다.

주로 0 으로 유지되다가 직선으로 올라가는 형태의 그래프를 띄고 있다.

ReLU 함수는

양의 값이 입력되면 그 값을 그대로 출력하고,

음의 값이 입력되면 0 을 반환한다.

코드 예시

def ReLU(x):

zero = np.zeros(len(x))

return np.max([zero, x], axis=0)

x = np.arange(-3, 3, .1)

y = ReLU(x)

fig = plt.figure()

ax = fig.add_subplot(111)

ax.plot(x, y)

ax.set_ylim([-1.0, 3.0])

ax.set_xlim([-3.0, 3.0])

#ax.grid(True)

ax.set_xlabel('z')

ax.set_title('ReLU: Rectified linear unit')

plt.show()

fig = plt.gcf()