-

퍼셉트론의 도식화 (Feat. 가중치, 가중합)Deep Learning (DL) 2022. 10. 28. 03:41

이전 포스트에서 예고했듯,

이번 글에서는 퍼셉트론의 도식화에 대해 자세히 알아보려한다.

퍼셉트론의 도식화 Constant

편향 (Bias) 라는 의미로, 고유한 값을 의미한다.

(Section2 의 Trade-Off 관계에서 등장한 편향과 딥러닝에서의 편향은 별개임을 명시한다.)

도식화 에서 볼 수 있듯,

크게 두 가지 부분으로 나눌 수 있다.

1. 가중치(Weight)-편향(bias) 연산

퍼셉트론은 여러 개의 신호를 입력 받는다.

입력된 신호는 각각의 가중치와 곱해지고 그 결과를 더해주는데,

이것을 가중 합 (Weighted Sum) (=가중치) 이라고 하며,

퍼셉트론의 첫 번째 단계이기도 하다.

import numpyas np input= np.array([1, 2, 3]) weight= np.array([0.2, 0.3,-0.1]) np.dot(input, weight) // 출력값 == 0.5 이다.

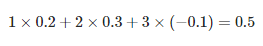

위 코드 블럭 풀이 즉, 입력 신호인 1과 가중치인 0.2 가 곱해지는 형태로 이어지게 된다.

위 형태가 누적되고 이를 모두 더한 값을 가중 합 이라고 한다.

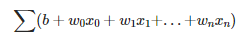

가중 합의 일반화 공식 일반화란?

특정 사례들의 공통되는 속성들을 일반적인 개념이나 주장으로 공식화하는 추상화의 한 형태이다.

https://ko.wikipedia.org/wiki/%EC%9D%BC%EB%B0%98%ED%99%94

일반화 - 위키백과, 우리 모두의 백과사전

위키백과, 우리 모두의 백과사전. 일반화(一般化, generalization)는 특정 사례들의 공통되는 속성들을 일반적인 개념이나 주장으로 공식화하는 추상화의 한 형태이다.[1][2] 일반적으로, A와 B라는 서

ko.wikipedia.org

2. 활성화 함수(Activation function)

활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고

값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다.

활성화 함수에 대해서는 다음 글에서 자세히 알아보도록 하자

https://battlecoding.tistory.com/52

활성화 함수 - 계단 함수 (Step function) 란?

활성화 함수(Activation function) 활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고 값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다

battlecoding.tistory.com

https://battlecoding.tistory.com/53

활성화 함수 - 시그모이드 함수(Sigmoid function) 란?

활성화 함수(Activation function) 활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고 값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다

battlecoding.tistory.com

https://battlecoding.tistory.com/54

활성화 함수 - ReLU 함수 (ReLU function) 란?

활성화 함수(Activation function) 활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고 값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다

battlecoding.tistory.com

https://battlecoding.tistory.com/55

활성화 함수 - 소프트맥스 함수 (Softmax function) 란?

활성화 함수(Activation function) 활성화 함수는 가중 합의 출력 값이 입력되었을 때, 그대로 출력 하지 않고 값을 증폭 시키거나, 감소 시키는 등 얼마 만큼의 신호로 출력 할 지 정해주는 함수이다

battlecoding.tistory.com

'Deep Learning (DL)' 카테고리의 다른 글

활성화 함수 - 소프트맥스 함수 (Softmax function) 란? (0) 2022.10.29 활성화 함수 - ReLU 함수 (ReLU function) 란? (0) 2022.10.29 활성화 함수 - 시그모이드 함수(Sigmoid function) 란? (0) 2022.10.29 활성화 함수 - 계단 함수 (Step function) 란? (0) 2022.10.29 퍼셉트론 (Perceptron) 이란? (0) 2022.10.27